Inhalt

- Big Data ist unstrukturiert oder halbstrukturiert

- Es macht keinen Sinn, Big Data zu speichern, wenn wir sie nicht verarbeiten können

- Wie Hadoop das Big-Data-Problem löst

- Der Business Case für Hadoop

Wegbringen:

Hadoop kann helfen, einige der großen Herausforderungen von Big Data zu lösen.

Big Data ist ... na ja ... groß! Wie viele Daten genau als Big Data klassifiziert werden können, ist nicht eindeutig. Für ein kleines Unternehmen, das es gewohnt ist, mit Daten in Gigabyte umzugehen, wären 10 TB Daten BIG. Für Unternehmen wie und Yahoo sind Petabytes jedoch groß.Die Größe der Big Data macht es unmöglich (oder zumindest unerschwinglich), sie in herkömmlichen Speichern wie Datenbanken oder herkömmlichen Filern zu speichern. Wir sprechen von den Kosten für die Speicherung von Gigabyte Daten. Die Verwendung von herkömmlichen Speicherfilern kann viel Geld kosten, um Big Data zu speichern.

Werfen Sie hier einen Blick auf Big Data, seine Herausforderungen und wie Hadoop sie lösen kann.Erstens sind Big Data die größten Herausforderungen.

Big Data ist unstrukturiert oder halbstrukturiert

Viele Big Data sind unstrukturiert. Klicken Sie beispielsweise auf Stream-Protokolldaten, um Folgendes anzuzeigen:Zeitstempel, user_id, page, referrer_page

Aufgrund der fehlenden Struktur sind relationale Datenbanken nicht für die Speicherung von Big Data geeignet. Außerdem können nicht viele Datenbanken Milliarden von Datenzeilen speichern.

Es macht keinen Sinn, Big Data zu speichern, wenn wir sie nicht verarbeiten können

Das Speichern von Big Data ist Teil des Spiels. Wir müssen es verarbeiten, um daraus Intelligenz zu gewinnen. Herkömmliche Speichersysteme sind in dem Sinne ziemlich "dumm", dass sie nur Bits speichern. Sie bieten keine Rechenleistung.Das herkömmliche Datenverarbeitungsmodell speichert Daten in einem Speichercluster, der zur Verarbeitung in einen Computercluster kopiert wird. Die Ergebnisse werden in den Speichercluster zurückgeschrieben.

Dieses Modell funktioniert jedoch nicht für Big Data, da das Kopieren so vieler Daten in einen Compute-Cluster möglicherweise zu zeitaufwändig oder unmöglich ist. Wie lautet also die Antwort?

Eine Lösung besteht darin, Big Data direkt zu verarbeiten, z. B. in einem Speichercluster, der gleichzeitig als Computercluster fungiert.

Wie wir oben gesehen haben, trotzt Big Data der herkömmlichen Speicherung. Wie gehen wir mit Big Data um?

Wie Hadoop das Big-Data-Problem löst

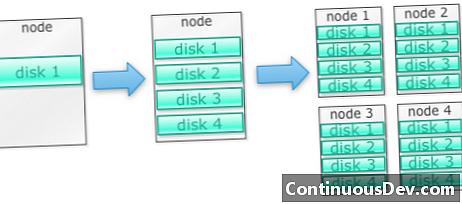

Hadoop kann auf mehreren Computern ausgeführt werdenBeginnen wir mit einem Beispiel. Nehmen wir an, wir müssen viele Fotos speichern. Wir werden mit einer einzelnen Platte beginnen. Wenn wir eine einzelne Festplatte überschreiten, verwenden wir möglicherweise einige Festplatten, die auf einem Computer gestapelt sind. Wenn wir alle Festplatten auf einer einzelnen Maschine voll ausschöpfen, müssen wir eine Reihe von Maschinen mit jeweils einer Reihe von Festplatten beschaffen.

Genau so ist Hadoop aufgebaut. Hadoop kann von Anfang an auf mehreren Computern ausgeführt werden.

Hadoop-Cluster werden horizontal skaliert

Sie können mehr Speicher und Rechenleistung erzielen, indem Sie einem Hadoop-Cluster weitere Knoten hinzufügen. Dadurch entfällt die Notwendigkeit, immer leistungsfähigere und teurere Hardware zu kaufen.

Hadoop kann mit unstrukturierten / halbstrukturierten Daten umgehen

Hadoop erzwingt kein Schema für die darin gespeicherten Daten. Es kann beliebige und binäre Daten verarbeiten. So kann Hadoop alle unstrukturierten Daten problemlos verarbeiten.

Hadoop-Cluster bieten Speicher und Computing

Wir haben festgestellt, dass getrennte Speicher- und Verarbeitungscluster nicht für Big Data geeignet sind. Hadoop-Cluster bieten jedoch Speicher und verteiltes Computing in einem.

Der Business Case für Hadoop

Hadoop bietet Speicherplatz für Big Data zu angemessenen Kosten

Das Speichern von Big Data mit herkömmlichem Speicher kann teuer sein. Hadoop basiert auf Standardhardware und bietet daher einen relativ großen Speicherplatz zu angemessenen Kosten. Hadoop wurde in der Praxis im Petabyte-Bereich eingesetzt.

Eine Studie von Cloudera ergab, dass Unternehmen normalerweise zwischen 25.000 und 50.000 USD pro Terabyte und Jahr ausgeben. Mit Hadoop sinken diese Kosten auf einige tausend Dollar pro Terabyte und Jahr. Da Hardware immer billiger wird, sinken diese Kosten weiter.

Mit Hadoop können Sie neue oder mehr Daten erfassen

Manchmal erfassen Unternehmen einen Datentyp nicht, weil das Speichern dieser Daten zu kostspielig war. Da Hadoop Speicher zu angemessenen Kosten bereitstellt, können diese Daten erfasst und gespeichert werden.

Ein Beispiel wären Website-Klickprotokolle. Da das Volumen dieser Protokolle sehr hoch sein kann, haben nicht viele Organisationen diese erfasst. Mit Hadoop ist es jetzt möglich, die Protokolle zu erfassen und zu speichern.

Mit Hadoop können Sie Daten länger speichern

Um das Volumen der gespeicherten Daten zu verwalten, bereinigen Unternehmen regelmäßig ältere Daten. Beispielsweise konnten nur Protokolle der letzten drei Monate gespeichert werden, während ältere Protokolle gelöscht wurden. Mit Hadoop ist es möglich, die historischen Daten länger zu speichern. Auf diese Weise können neue Analysen für ältere historische Daten durchgeführt werden.

Nehmen Sie zum Beispiel Klickprotokolle von einer Website. Vor einigen Jahren wurden diese Protokolle für einen kurzen Zeitraum gespeichert, um Statistiken wie beliebte Seiten zu berechnen. Mit Hadoop ist es jetzt möglich, diese Klickprotokolle für einen längeren Zeitraum zu speichern.

Hadoop bietet skalierbare Analysen

Es macht keinen Sinn, all diese Daten zu speichern, wenn wir sie nicht analysieren können. Hadoop bietet nicht nur verteilten Speicher, sondern auch verteilte Verarbeitung, sodass wir eine große Datenmenge parallel verarbeiten können. Das Rechenframework von Hadoop heißt MapReduce. MapReduce hat sich im Petabyte-Maßstab bewährt.

Hadoop bietet umfassende Analysefunktionen

Native MapReduce unterstützt Java als primäre Programmiersprache. Andere Sprachen wie Ruby, Python und R können ebenfalls verwendet werden.

Das Schreiben von benutzerdefiniertem MapReduce-Code ist natürlich nicht die einzige Möglichkeit, Daten in Hadoop zu analysieren. Kartenverkleinerung auf höherer Ebene ist verfügbar. Ein Tool namens Pig übernimmt beispielsweise die englische Sprache für den Datenfluss und übersetzt sie in MapReduce. Ein anderes Tool, Hive, nimmt SQL-Abfragen entgegen und führt sie mit MapReduce aus.

Mit Business Intelligence-Tools (BI) können noch umfassendere Analysen durchgeführt werden. Es gibt auch Werkzeuge für diese Art der Analyse.

Dieser Inhalt ist ein Auszug aus "Hadoop Illuminated" von Mark Kerzner und Sujee Maniyam. Es wurde über die Creative Commons Namensnennung-Keine kommerzielle Nutzung-Weitergabe unter gleichen Bedingungen 3.0 Unported-Lizenz zur Verfügung gestellt.