Inhalt

Q:

Warum sind künstliche neuronale Netze oft schwer zu trainieren?

EIN:

Die Schwierigkeit, künstlich wiederkehrende neuronale Netze zu trainieren, hängt mit ihrer Komplexität zusammen.

Eine der einfachsten Möglichkeiten, um zu erklären, warum sich rekurrente neuronale Netze nur schwer trainieren lassen, besteht darin, dass es sich nicht um vorwärtsgerichtete neuronale Netze handelt.

In vorwärtsgerichteten neuronalen Netzen bewegen sich die Signale nur in eine Richtung. Das Signal bewegt sich von einer Eingangsschicht zu verschiedenen verborgenen Schichten und weiter zur Ausgangsschicht eines Systems.

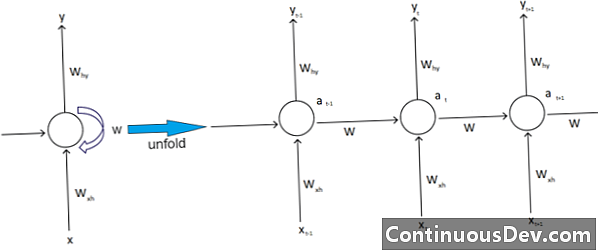

Im Gegensatz dazu weisen wiederkehrende neuronale Netze und andere unterschiedliche Arten von neuronalen Netzen komplexere Signalbewegungen auf. Wiederkehrende neuronale Netze, die als "Rückkopplungs" -Netze klassifiziert sind, können sowohl vorwärts als auch rückwärts laufende Signale haben und können verschiedene "Schleifen" im Netz enthalten, in die Zahlen oder Werte in das Netz zurückgeführt werden. Experten assoziieren dies mit dem Aspekt wiederkehrender neuronaler Netze, der mit ihrem Gedächtnis assoziiert ist.

Darüber hinaus gibt es eine andere Art von Komplexität, die sich auf wiederkehrende neuronale Netze auswirkt. Ein hervorragendes Beispiel hierfür ist die Verarbeitung natürlicher Sprache.

Bei der Verarbeitung natürlicher Sprache muss das neuronale Netzwerk in der Lage sein, sich an Dinge zu erinnern. Es muss auch Eingaben in con nehmen. Angenommen, es gibt ein Programm, das ein Wort innerhalb eines Satzes anderer Wörter analysieren oder vorhersagen möchte. Es kann zum Beispiel eine feste Länge von fünf Wörtern geben, die das System auswerten kann. Das bedeutet, dass das neuronale Netzwerk für jedes dieser Wörter Eingaben haben muss, zusammen mit der Fähigkeit, sich an den Inhalt dieser Wörter zu erinnern oder ihn zu trainieren. Aus diesen und ähnlichen Gründen weisen wiederkehrende neuronale Netze typischerweise diese kleinen versteckten Schleifen und Rückkopplungen im System auf.

Experten beklagen, dass diese Komplikationen es schwierig machen, die Netzwerke zu trainieren. Eine der häufigsten Erklärungsmöglichkeiten ist das explodierende und verschwindende Gradientenproblem. Im Wesentlichen führen die Gewichte des Netzwerks bei einer großen Anzahl von Durchläufen entweder zu einer Explosion oder zu einem Verschwinden von Werten.

Geoff Hinton, Pionier des neuronalen Netzwerks, erklärt dieses Phänomen im Internet, indem er sagt, dass rückwärtsgerichtete lineare Übergänge dazu führen, dass kleinere Gewichte exponentiell schrumpfen und größere Gewichte explodieren.

Dieses Problem verschlimmere sich mit langen Sequenzen und mehr Zeitschritten, in denen die Signale wachsen oder zerfallen. Die Gewichtungsinitialisierung mag helfen, aber diese Herausforderungen sind in das wiederkehrende neuronale Netzwerkmodell integriert. Es wird immer das Problem sein, das mit ihrem speziellen Design und ihrer Konstruktion verbunden ist. Einige der komplexeren Arten von neuronalen Netzen sind im Grunde genommen nicht in der Lage, sie einfach zu verwalten. Wir können praktisch unendlich viel Komplexität erzeugen, sehen jedoch häufig wachsende Herausforderungen in Bezug auf Vorhersagbarkeit und Skalierbarkeit.