Inhalt

- Definition - Was bedeutet Hadoop-Ökosystem?

- Eine Einführung in Microsoft Azure und die Microsoft Cloud | In diesem Handbuch erfahren Sie, worum es beim Cloud-Computing geht und wie Microsoft Azure Sie bei der Migration und Ausführung Ihres Unternehmens aus der Cloud unterstützen kann.

- Techopedia erklärt das Hadoop-Ökosystem

Definition - Was bedeutet Hadoop-Ökosystem?

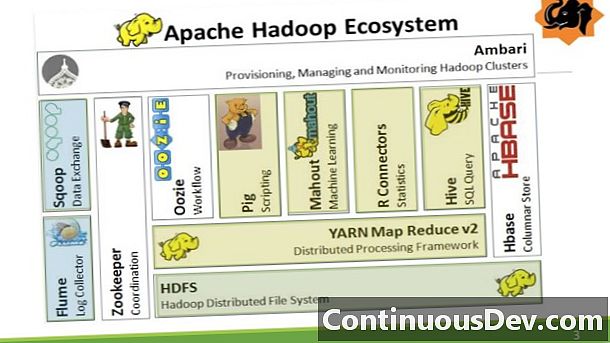

Das Hadoop-Ökosystem verweist auf die verschiedenen Komponenten der Apache Hadoop-Softwarebibliothek sowie auf das Zubehör und die Tools, die von der Apache Software Foundation für diese Art von Softwareprojekten bereitgestellt werden, und auf die Art und Weise, wie diese zusammenarbeiten.

Hadoop ist ein Java-basiertes Framework, das für die Verarbeitung und Analyse großer Datenmengen äußerst beliebt ist.

Eine Einführung in Microsoft Azure und die Microsoft Cloud | In diesem Handbuch erfahren Sie, worum es beim Cloud-Computing geht und wie Microsoft Azure Sie bei der Migration und Ausführung Ihres Unternehmens aus der Cloud unterstützen kann.

Techopedia erklärt das Hadoop-Ökosystem

Sowohl das Kernpaket von Hadoop als auch dessen Zubehör sind meist Open-Source-Projekte, die von Apache lizenziert werden. Die Idee eines Hadoop-Ökosystems besteht darin, verschiedene Teile des Hadoop-Kernsatzes zu verwenden, z. B. MapReduce, ein Framework für die Verarbeitung großer Datenmengen, und das Hadoop Distributed File System (HDFS), ein hochentwickeltes Dateibehandlungssystem. Es gibt auch YARN, einen Hadoop-Ressourcenmanager.

Zusätzlich zu diesen Kernelementen von Hadoop hat Apache auch andere Arten von Zubehör oder ergänzende Tools für Entwickler geliefert. Dazu gehören Apache Hive, ein Datenanalysetool; Apache Spark, eine allgemeine Engine zur Verarbeitung von Big Data; Apache Pig, eine Datenflusssprache; HBase, ein Datenbankwerkzeug; und auch Ambarl, das als Hadoop-Ökosystemmanager betrachtet werden kann, da es dabei hilft, die Verwendung dieser verschiedenen Apache-Ressourcen zusammen zu verwalten. Da Hadoop zum De-facto-Standard für die Datenerfassung wird und in vielen Organisationen allgegenwärtig ist, lernen Manager und Entwicklungsleiter alles über das Hadoop-Ökosystem und welche Dinge in einem allgemeinen Hadoop-Setup stecken.